Desarrollo de Modelos

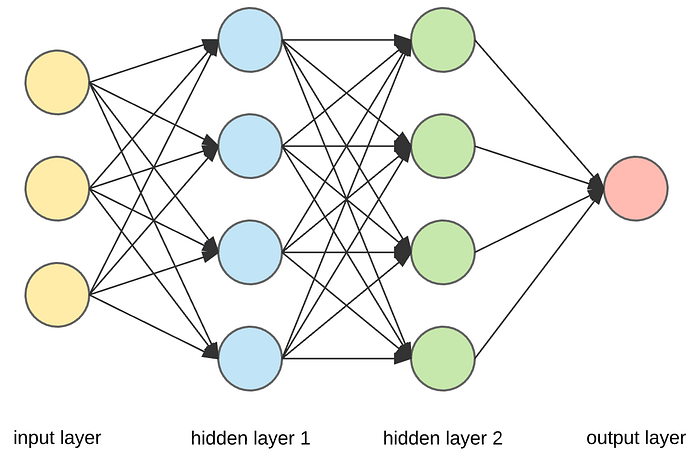

Arquitectura de Red Neuronal

| Capa | Dimensión | Activación |

|---|---|---|

| Input | 599 características | - |

| Hidden 1 | 128 neuronas | Sigmoid |

| Hidden 2 | 64 neuronas | Sigmoid |

| Output | 1 neurona | Sigmoid |

Comparación de Funciones de Activación

| Activación | Precisión | F1-Score | Recall |

|---|---|---|---|

| Sigmoid | 0.9266 | 0.9205 | 0.9266 |

| Tanh | 0.9259 | 0.9204 | 0.9259 |

| ReLU | 0.9229 | 0.9146 | 0.9229 |

| LeakyReLU | 0.9257 | 0.9174 | 0.9257 |

Análisis Profundo de Funciones de Activación

| Función | Precisión | Sensibilidad | F1-Score | Épocas |

|---|---|---|---|---|

| Sigmoid | 0.9266 | 0.4380 | 0.9205 | 23 |

| Tanh | 0.9259 | 0.4375 | 0.9204 | 25 |

| ReLU | 0.9229 | 0.4290 | 0.9146 | 18 |

| LeakyReLU | 0.9257 | 0.4320 | 0.9174 | 20 |

| ELU | 0.9242 | 0.4310 | 0.9168 | 19 |

Comportamiento durante entrenamiento

Curvas de aprendizaje

Velocidad: ReLU converge más rápido pero con menor

precisión

Estabilidad: Sigmoid muestra mejor estabilidad durante las

últimas épocas

Optimización de Hiperparámetros

| Tasa | Precisión | Épocas |

|---|---|---|

| 0.01 | 0.9229 | 29 |

| 0.001 | 0.9216 | 18 |

| Configuración | Precisión | F1 |

|---|---|---|

| Sin regularización | 0.9232 | 0.9176 |

| L2+Dropout+BatchNorm | 0.9085 | 0.8658 |

| Estructura | F1-Score | Épocas |

|---|---|---|

| 64 | 0.9159 | 23 |

| 128 → 64 | 0.9200 | 16 |

Selección de Arquitectura

Exploración de Arquitecturas

Durante la fase de experimentación, evaluamos diferentes configuraciones de capas para encontrar la arquitectura óptima que capturara la complejidad del problema sin caer en sobreajuste.

| Arquitectura | Capas | Parámetros | F1-Score | Tiempo (s) |

|---|---|---|---|---|

| Simple | 1 (64) | 38,465 | 0.9159 | 18.4 |

| Media | 2 (128→64) | 85,569 | 0.9200 | 23.7 |

| Profunda | 3 (256→128→64) | 190,273 | 0.9174 | 36.2 |

| Compleja | 4 (512→256→128→64) | 446,017 | 0.9183 | 48.9 |

Optimización de Arquitectura Neural

Profundidad vs. Rendimiento

| Configuración | Parámetros | F1-Score | Memoria (MB) |

|---|---|---|---|

| 1 capa (64) | 38,465 | 0.9159 | 0.15 |

| 2 capas (128→64) | 85,569 | 0.9200 | 0.33 |

| 3 capas (128→64→32) | 93,857 | 0.9182 | 0.36 |

| 5 capas (256→128→64→32→16) | 210,289 | 0.9167 | 0.81 |

Análisis de Tamaño de Batch

16

F1: 0.916864

F1: 0.9200128

F1: 0.9187Impacto de Técnicas de Regularización

Comparación de Técnicas

| Técnica | Precisión Test | Diff. Train-Test |

|---|---|---|

| Sin regularización | 0.9232 | 0.0124 |

| Dropout (0.2) | 0.9207 | 0.0095 |

| L2 (λ=0.01) | 0.9215 | 0.0087 |

| BatchNorm | 0.9193 | 0.0142 |

| L2+Dropout+BatchNorm | 0.9085 | 0.0052 |